📌 Introdução

O Apache Spark é um framework de código aberto para computação distribuída, projetado para processar grandes conjuntos de dados com alta performance. Criado pela Universidade da Califórnia, em Berkeley, ele se destaca por sua velocidade, facilidade de uso e suporte a múltiplas tarefas, desde análises simples até complexos algoritmos de aprendizado de máquina.

Neste artigo, exploraremos as principais características do Apache Spark, suas vantagens, casos de uso e como ele tem revolucionado o processamento de dados no contexto do Big Data.

⚙️ Características Principais do Apache Spark

🚀 Processamento em Memória

Uma das maiores vantagens do Spark é a sua capacidade de processar dados em memória, reduzindo significativamente o tempo de execução quando comparado a sistemas baseados em disco, como o Hadoop MapReduce. Em alguns casos, isso pode resultar em operações até 100 vezes mais rápidas.

🖥️ API Simples e Flexível

O Spark oferece suporte a diversas linguagens de programação, como Java, Scala, Python e R, tornando-o acessível para diferentes perfis de profissionais, desde engenheiros de dados até cientistas de dados

🔌 Suporte a Vários Módulos

O Apache Spark não é apenas um framework de processamento de dados, mas uma plataforma completa, que inclui:

-

Spark SQL: Para manipulação e consulta de dados estruturados.

-

MLlib: Biblioteca para aprendizado de máquina.

-

Structured Streaming: Para processamento de dados em tempo real.

-

GraphX: Para análise de grafos.

-

📈 Escalabilidade

Projetado para execução em clusters de computação, o Spark permite que as organizações escalem suas operações de processamento de dados facilmente, podendo ser implantado tanto em ambientes locais quanto em nuvem.

🎯 Vantagens do Apache Spark

✅ Alta Performance: Processamento em memória e execução paralela garantem desempenho superior em relação a outras soluções de Big Data.

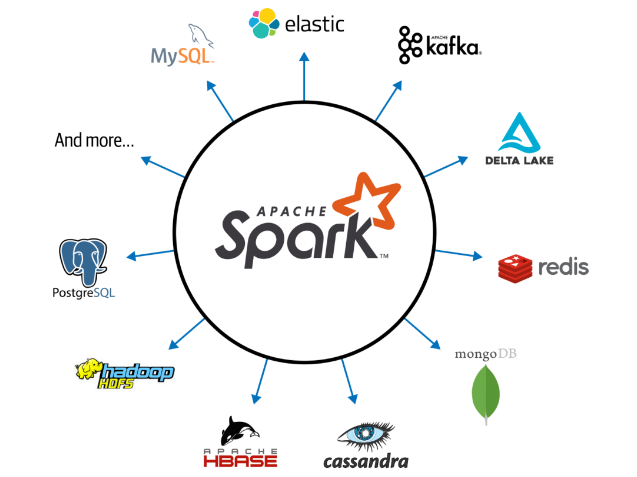

✅ Facilidade de Integração: O Spark se integra facilmente com ferramentas populares, como Hadoop, Hive e bancos de dados NoSQL.

✅ Ampla Comunidade e Suporte: Sendo um projeto de código aberto, o Spark possui uma grande comunidade ativa, oferecendo vasta documentação e suporte para desenvolvedores e empresas.

💡 Casos de Uso do Apache Spark

📊 Análise de Dados

Empresas utilizam o Spark para processar e analisar grandes volumes de dados rapidamente, extraindo insights valiosos para tomada de decisões.

🔄 Processamento de Streams

O módulo Structured Streaming permite o processamento de dados em tempo real, sendo ideal para aplicações como monitoramento de redes sociais, análise de logs e detecção de fraudes.

🤖 Machine Learning

Com a biblioteca MLlib, o Spark facilita a implementação de modelos de aprendizado de máquina em larga escala, sendo amplamente utilizado para análise preditiva e automação de processos.

🔄 ETL (Extração, Transformação e Carga)

O Spark é uma ferramenta essencial em pipelines de ETL, permitindo a extração de dados de múltiplas fontes, sua transformação conforme necessário e o carregamento em sistemas de armazenamento.

🔚 Conclusão

O Apache Spark representa uma verdadeira revolução no processamento de dados, trazendo alto desempenho, escalabilidade e flexibilidade. Sua capacidade de lidar com diferentes tipos de processamento, aliada à ampla adoção e suporte da comunidade, faz dele uma ferramenta indispensável para empresas que buscam eficiência em suas operações de dados.

Se você está considerando adotar o Spark, este é o momento ideal para explorar suas capacidades e elevar suas análises de dados a um novo patamar.

🚀

📚 Referências e Links Úteis